Bonjour,

J’espère que vous allez bien,

De mon côté, tout va bien, et j’ai hâte de vous présenter le programme de cette newsletter.

Ce que vous allez apprendre en plus dans cette newsletter :

Comment publier des posts Linkedin de qualité avec l'IA en septembre 2025 ?

Pourquoi l’IA met en danger les profils juniors en entreprise

Un outil pour la documentation d’outil métier

Deux papiers de recherches (dont un d’OpenAI) sur les hallucinations et le déterminismes de LLMs

Un prompt très utile pour créer des automatisations N8N

Le conseil de ce multi-milliardiaire américain de 29 ans va vous surprendre !

(IMAGES) Un super-template pour créer une landing page efficace pour votre SAAS IA

Et bien plus encore !

C’est parti !

Excellente journée,

Jean-Baptiste.

Je m’appelle Jean-Baptiste Berthoux, je suis le co-fondateur de MAIjin. Depuis Janvier 2023, j’ai accompagné 2100 professionnels et 100 organisations à gagner du temps avec l’IA générative. Je me désigne comme un expert des usages de l’IA générative dans le milieu professionnel. Chaque semaine, depuis 167 éditions, j'envoie ma newsletter qui démystifie le monde de l’IA en pleine ébullition.

- Merci aux 64 nouveaux abonnées/abonnés qui ont rejoint cette newsletter

- Nous sommes maintenant 3967

- N’hésitez donc pas à partager le lien d’inscription à vos proches

De plus, si ce n’est pas fait déjà fait, vous pouvez aussi :

- Me suivre sur Linkedin où je partage mes idées chaque jour (17 210 abonnés)

- Me contacter pour une formation ou un audit pour votre entreprise

- Faire un diagnostic IA gratuit de votre entreprise

Les nouveautés de la semaine

Bientôt, vous aurez le droit à votre dose d’information quotidienne basée sur vos questions ChatGPT. OpenAI lance ChatGPT pulse. Disponible que chez les abonnés Pro. Contrairement au modèle de Google qui examine votre intention et vous donne des résultats en rapport avec ce que vous cherchez. OpenAI prend le contre-pied. ChatGPT analyse ce que vous aimez pendant la nuit et vous envoie du contenu adapté tous les matins. Vous pouvez aussi lui donner accès à vos emails et votre calendrier pour davantage de personnalisation. L’idée est de se démarquer du modèle de la publicité qui retient votre attention et de vous proposer un contenu à temps limité ultra personnalisé. Le risque que je vois est que cela continue de confirmer nos biais et nous enferme dans une bulle algorithmique encore plus forte. Après libre à nous de lui demander des informations qui nous ouvrent l’esprit. Et vous, que pensez-vous de ChatGPT Pulse ?

L’or du 21ème siècle bascule de l’attention au SIllicium qui permet d’avoir de la puissance de calcul. 500 milliards pour OpenAI via Softbank et Oracle.

Vous pouvez désormais “partager vos projets” dans ChatGPT Business avec les membres de vos équipes. Les projets sont de plus en plus utilisés dans les entreprises que j’accompagne. Il manquait vraiment cette possibiltié de travailler sur des projets partagés. Je suis heureux qu’OpenAI ait passé le cap.

Greg Isenberg est un youtubeur IA / business pointu. Si vous vous lancez un business dans l’IA, il est une source fiable (il y a de tout et n’importe quoi dans ce monde…). Il a lancé un documentaire sur l’IA en faisant un parallèle avec la ruée vers l’or. Je trouve le concept de documentaire business chouette : https://www.youtube.com/watch?v=1DXhi40aNfs&t=25s

Suno, l’outil numéro 1 de création de musique avec l’IA sort son modèle V5. J’ai testé et le résultat est dingue. Je vois une tendance dans mon entourage pro-technologie, des personnes créés des musiques IA personnalisées pour leurs parents, leurs enfants, leurs amis…et finissent par écouter davantage ces musiques que les musiques “commerciales”. Bientôt, vous pourrez créer vos séries personnalisées Netflix, vos livres préférées, et peut être même vos jeux vidéos préférés. En somme, l’IA créé l’ultra personnalisation de la production artistique. De plus, les consommateurs d’antan deviennent les acteurs de leur production.

Tendance : les outils IA se verticalisent. Après Harvey, Wilson créé est un outil dédié aux avocats : https://getwilson.ai/

Vous pouvez acheter des jouets IA pour enfants :

Les chinois de Qwen lancent un nouveau modèle :

L’outil de la semaine - https://www.trupeer.ai

Interface de Blocks

Qui rêve de faire des tutoriels vidéo de son logiciel métier ? Pas grand monde si j’en crois mes interventions en entreprise. Trupeer intervient exactement ici, en vous permettant de faire des vidéos tutoriels rapidement avec l’IA à partir d’un screenshot ou d’une vidéo Loom sans que vous parliez. Un gain de temps et une baisse de pénibilité importante.

Le guide de la semaine : comment rendre les LLMs déterministes et les empêcher d’halluciner ?

Bonjour,

En formation, je rencontre des professionnels qui voudrait que l’IA donne toujours le même type de réponse, au lieu de générer des nouvelles réponses à chaque fois.

De plus, beaucoup sont frustrés des erreurs factuelles produites par les LLMs.

Le résultat ? Ils ne font pas confiance aux nouveaux outils d’IA et n’utilisent pas d’outils.

Ces frustrations sont visibles chez les pros dont le besoin de réponse précise est important comme dans la santé ou la finance.

Depuis la création des LLMs, personne n’avait trouvé la réponse à ces deux problématiques.

Heureusement, dans les dernières semaines, deux papiers tonitruants ont forgé de nouveaux espoirs.

L’un vient de Thinking Machine Labs, l’entreprise de l’ancienne CTO d’Open AI Mira Murati. L’autre papier de recherche nous vient d’Open AI.

Dans les minutes qui suivent, je vous propose un explication pour les néophytes.

En lisant ces lignes, vous pourrez montrer votre intelligence supérieure auprès de vos collègues face à la machine à café en disant : "Les LLMs qui hallucinent ne sont pas une fatalité”.

Let’s go 🙂

Defeating Nondeterminism in LLM Inference est un papier de recherche en collaboration avec l’entreprise de Mira Murati, ex CTO d’Open AI.

Il y a un problème avec les LLMs, il est difficile d’obtenir toujours la même réponse à une même question, même si le degré de créativité (température) est à zéro.

Or, c’est embêtant, car chez les analystes financiers, en sciences, ou chez les avocats, on veut que l’IA nous donne toujours la MÊME réponse.

Ce problème vient lors du traitement de l’information lors du calcul dans les centres de données.

Le serveur traite plusieurs utilisateurs en même temps.

Et votre prompt peut être traité en petit batch (groupe) ou gros batch, et cela crée des micro-différences.

Celles-ci s’accumulent et finissent par faire varier les réponses.

Les chercheurs ont donc créé une méthode de calcul qui ne varie pas en fonction de la quantité calculée. Ils ont appelé ça des calculs “batch-invariants”.

C’est super car le le résultat ne dépend plus du nombre de requêtes traitées en parallèle. Il est donc possible d’obtenir des résultats 100% reproductibles.

Ces calculs “batch invariants” font néanmoins perdre en rapidité de calcul.

Résultat ? Ca coute plus de $$$.

Il reste donc des obstacles pour rendre cette méthode accessible au grand public.

Un LLM : “Non, mais j’hallucine PLUS DU TOUT” !

Image générée avec ChatGPT

OpenAI a sorti un papier : Pourquoi les LLM hallucinent ?.

Une hallucination ou texte synthétisé non fondé est quand le modèle de langage répond faux à une question de manière plausible et avec une grande confiance.

Les hallucinations sont difficiles à repérer et causent de forts préjudices dans le milieu professionnel, surtout chez ceux qui ont besoin d’une forte exactitude.

L’entreprise de Sam Altman a découvert une piste pour réduire ces erreurs et je vais vous dire laquelle c’est.

Les modèles de langage sont évalués par des “benchmarks”, des tests, et leur but est de donner le plus de réponses exactes possibles.

Mais il y a un soucis dans la notation.

Ces tests récompensent fortement les bonnes réponses, mais si le LLM répond “Je sais pas”, alors il est sûr d’avoir zéro point.

Donc comme pour nous dans un QCM, il vaut mieux tenter, “bluffer” et avec de la chance d'avoir des points, plutôt que de s’assurer d’un zéro point.

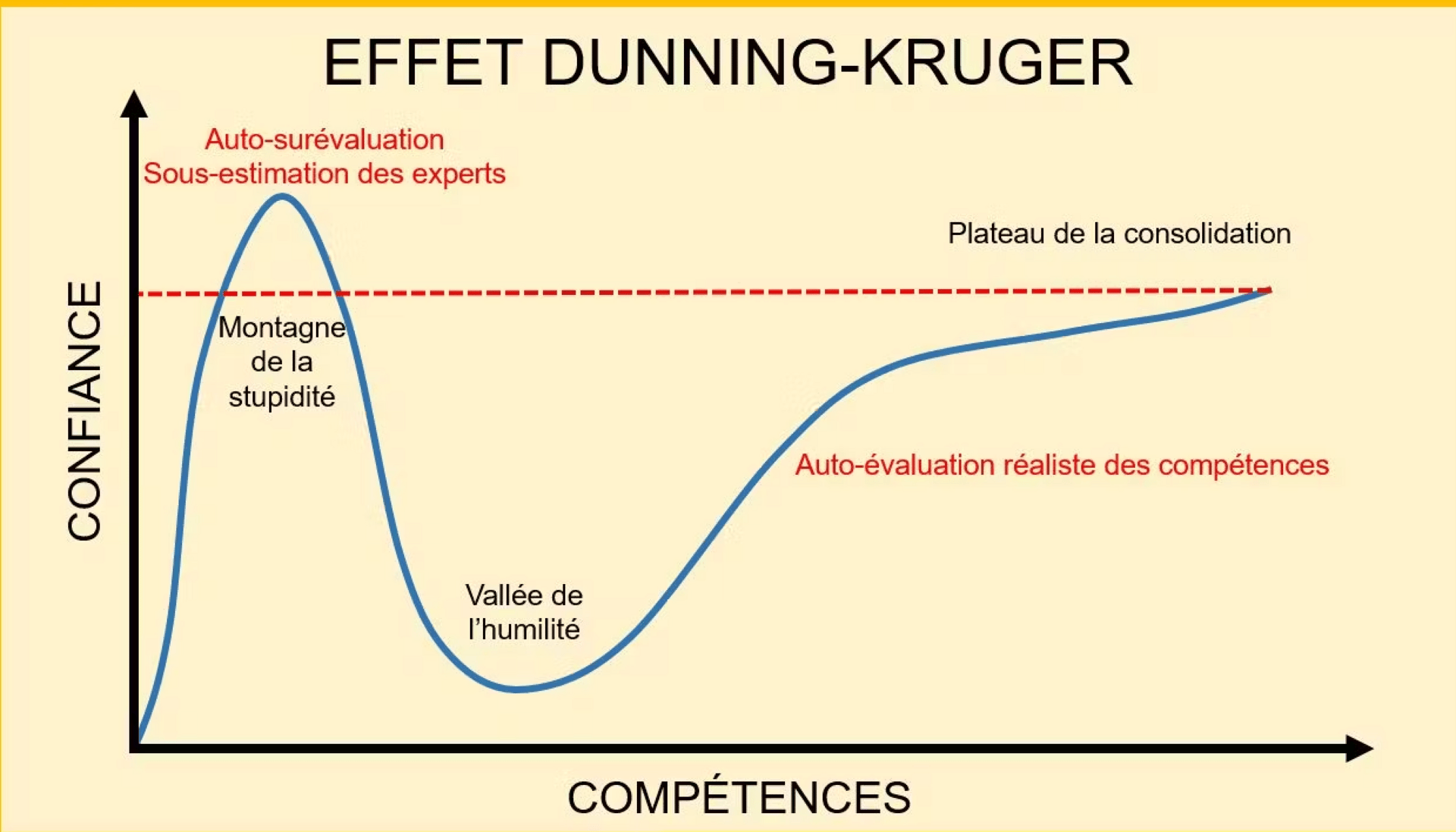

Je trouve ça fascinant. Cette étude me fait penser à l’effet de Dunning Kruger, un biais cognitif humain.

Quand nous apprenons un sujet, nous nous sentons très confiant et atteignons la montagne de la stupidité. Puis en creusant le sujet, nous devenons humble. Ah, en fait, je croyais que je savais tout, mais je me rends compte que je ne sais rien. Nous devenons plus matures et savons évaluer nos compétences de manière réelle.

Les LLMs semblent suivre la même trajectoire. Après les avoir entraînés à dire tout et n’importe quoi de manière confiante, les chercheurs vont les entraîner à devenir sages. Ils vont être capable de dire : “je ne suis pas sûr” ou “je ne sais pas”. Encore une fois, cela montre à quel point ces machines ont des caractéristiques para-humaines.

Conclusion :

Ces deux études montrent que les chercheurs en IA avancent à une vitesse folle.

Nous aurons le droit à plusieurs approches :

Des modèles lents mais exacts

Des modèles sages

Des modèles entrainées à inventer au maximum pour être créatifs

Bientôt, nous ne parlerons plus des modèles de langage mais bien de multiples sous-familles des LLMs.

Qu’en dites-vous ?

Jean-Baptiste

Le fait surprenant de la semaine - Faites vibe coder vos enfants !

À seulement 28 ans, Alexandr Wang — fondateur de Scale AI et désormais Chief AI Officer de Meta — bouscule le débat sur l’éducation numérique. Selon lui, les adolescents devraient consacrer leur temps libre à “vibe-coder”, une nouvelle approche de la programmation où l’on dialogue avec une intelligence artificielle en langage naturel pour générer du code automatiquement. Autrement dit, n’importe qui, sans formation technique, peut désormais créer une application ou un site web en “parlant” à une IA. Plus frappant encore : Wang estime que d’ici cinq ans, l’IA sera capable de reproduire l’intégralité du code qu’il a produit dans sa carrière, lui qui a dirigé une startup valorisée à 29 milliards de dollars. Une affirmation qui rejoint celle de Jensen Huang (Nvidia), pour qui la nouvelle langue de programmation est… le langage humain. Ce basculement soulève une question vertigineuse : faut-il encore enseigner le code aux jeunes, ou leur apprendre avant tout à dialoguer efficacement avec les machines ? Derrière cette vision se dessine un futur où un collégien motivé pourrait bâtir un prototype en un après-midi — une perspective à la fois enthousiasmante et déstabilisante pour l’école et le monde du travail.

La notion de la semaine - quand l’IA dépasse vos junions

Source : Exponential View

L’IA surpasse probablement déjà 50 à 70 % de ta main-d’œuvre sur des tâches définies. Le nouveau test d’OpenAI, GDPval, montre que les modèles sont presque au niveau des experts sectoriels, qui ont en moyenne 14 ans d’expérience. Si les modèles sont aussi bons, voire meilleurs, que les experts dans environ 47 % des tâches, ils sont probablement plus proches de 70 à 80 % lorsqu’on les compare à des juniors n’ayant que deux ou trois ans d’expérience. En d’autres termes, tes analystes juniors, tes jeunes avocats et tes nouveaux chargés marketing sont déjà dépassés par l’IA.

Nous suivons cette évolution depuis un certain temps. Plus récemment, en janvier, nous not ions dans « Jevons and the automated developer » que l’IA redéfinissait le travail d’entrée de gamme dans le logiciel : les machines pouvaient gérer davantage de tâches répétitives, mais la supervision humaine et le jugement architectural restaient essentiels. À l’été, de nouvelles preuves sont arrivées. Le mois dernier, nous avons étudié les recherches d’Erik Brynjolfsson montrant que le recrutement en début de carrière dans les secteurs exposés à l’IA diminuait, alors que la demande pour les travailleurs expérimentés augmentait.

Nous faisons face à un problème épineux… Une IA évaluée par des benchmarks est un concurrent crédible du travail humain sur les tâches. Supposons que ce soit déjà un moteur majeur des décisions des entreprises. Qu’est-ce que cela implique ?

D’abord, les entreprises suspendent l’embauche de juniors le temps que les managers identifient ce qui peut être automatisé pour réduire les coûts sans avoir à licencier.

Ensuite, elles commencent à écarter ceux qui ne s’adaptent pas. Accenture est clair là-dessus : se former à l’IA ou être « sorti », même si l’entreprise recrute sélectivement pour des postes liés à l’IA. D’autres sociétés feront de même.

Enfin, l’expérience reste un atout. Les personnes ayant une solide expertise métier et de l’expérience savent mieux formuler des prompts et évaluer le travail des modèles.

Les études montrent que l’expertise renforce la capacité à déléguer et à vérifier. Mais cet avantage pour les travailleurs expérimentés pourrait n’être que temporaire. Sur de nouveaux benchmarks plus difficiles, les modèles de pointe s’améliorent de plusieurs dizaines de pourcents chaque année, réduisant l’écart entre experts et machines. Les compétences complémentaires de nos superviseurs d’IA nécessitent donc une mise à jour continue.

Le résultat, c’est un changement fondamental dans la division du travail, les tâches étant de plus en plus centralisées. Cela va probablement réduire les incitations générales des employeurs à investir dans leurs collaborateurs.

Voilà où réside la difficulté : il faut construire de nouveaux ensembles de compétences pour gérer des systèmes capables de dépasser leurs responsables humains. Mais « de nouvelles compétences », c’est facile à exiger et difficile à délivrer. La pédagogie, les rôles et les incitations prennent toujours du retard.

Le prompt de la semaine - Créer des automatisations N8N simplement

Tu es un expert en automatisation de workflows n8n avec plus de 5 ans d’expérience dans la création d’agents IA de niveau production. Ta mission est de m’aider à construire un workflow n8n complet d’agent IA pour [DÉCRIS TON CAS D’USAGE].

CONTEXTE SUR MES BESOINS :

Cas d’usage : [Décris ce que tu veux que l’agent fasse]

Sources de données : [Liste tes entrées — e-mails, API, bases de données, etc.]

Résultats attendus : [Ce que l’agent doit produire/faire]

Intégrations nécessaires : [Slack, Gmail, Notion, etc.]

Niveau de complexité : [Débutant/Intermédiaire/Avancé]

EXIGENCES :

Concevoir l’architecture complète du workflow

Fournir la configuration des nœuds n8n étape par étape

Inclure la gestion des erreurs et une logique de nouvelle tentative (retry)

Ajouter des étapes de validation et de transformation des données

Proposer des optimisations pour un usage en production

LIVRABLES ATTENDUS :

□ Description du diagramme du workflow

□ Instructions complètes de configuration nœud par nœud

□ Structure du fichier JSON du workflow

□ Checklist de test et de débogage

□ Recommandations de passage à l’échelle

SPÉCIFICATIONS TECHNIQUES :

Utiliser l’API Claude/OpenAI pour le traitement IA

Inclure des déclencheurs (webhooks) lorsque pertinent

Ajouter un assainissement/nettoyage correct des données

Mettre en place une journalisation (logging) pour le diagnostic

Suivre les bonnes pratiques n8n pour le nommage des nœuds

CONTRAINTES :

- Le rendre prêt pour la production, pas une démo

- Optimiser la fiabilité plutôt que la complexité

- Inclure des mécanismes de repli (fallback)

- Le rendre maintenable par quelqu’un d’autre

EXEMPLES À INCLURE :

- Exemples de formats de données d’entrée/sortie

- Cas limites courants et leurs solutions

- Benchmarks de performance si pertinent

FORMAT ÉTAPE PAR ÉTAPE :

- Vue d’ensemble de l’architecture

- Séquence des nœuds avec configurations

- Cartographie des connexions entre les nœuds

- Variables d’environnement nécessaires

- Checklist de déploiement

Commence par poser des questions de clarification sur mon cas d’usage spécifique, puis fournis le plan d’implémentation complet.How To - Publier des posts Linkedin de qualité, avec votre ton de voice, sans rédiger une seule ligne.

Source : @rowancheung, adaptation par moi même.

1. Téléchargez une application de dictée vocale alimentée par l'IA sur votre téléphone. J’utile un projet ChatGPT “Notes Vocales”.

2. Faites de longues promenades et laissez les idées circuler - lorsque vous en avez une bonne, ouvrez ChatGPT et divaguez (il n'est pas nécessaire que ce soit parfait)

3. Enregistrement automatique des notes. Elles deviennent les idées principales des publications ultérieures.

4. Ouvrez Claude/ChatGPT et créez un nouveau projet appelé « Post generateur »

5. Utilisez ce prompt

Je vais vous fournir mon propre texte, et votre tâche sera de comprendre et d'en reproduire le style. Vous commencerez cet exercice en disant « COMMENCER ». Ensuite, je vous présenterai un exemple de texte, auquel vous répondrez « CONTINUER ». Le processus se poursuivra de la même manière avec un autre texte, puis avec d'autres exemples. Je vous donnerai un nombre illimité d'exemples. Votre seule réponse sera « CONTINUER ». Vous ne pourrez modifier votre réponse que lorsque je vous dirai « TERMINÉ ». Ensuite, vous explorerez et comprendrez le ton, le style et les caractéristiques de mon écriture à partir des exemples que je vous ai donnés. Enfin, je vous demanderai de rédiger un nouveau texte sur un sujet précis, en imitant mon style d'écriture caractéristique. 6. Maintenant, c'est la partie amusante : accédez à Linkedin et téléchargez vos meilleurs posts.

7. Collez vos posts les plus performants dans Claude/ChatGPT à plusieurs reprises jusqu'à ce qu'il indique « TERMINÉ ».

8. Prenez vos notes vocales, collez-les dans votre projet Claude/ChatGPT formé, ajoutez ce prompt « créer un article dans mon style d'écriture »

9. Le message est prêt à être publié. Peaufinez-le et modifiez-le légèrement si nécessaire.

Voilà 🙂

La vidéo de la semaine - Créer une bonne landing page pour votre SAAS IA

Copier ça sur Lovable avant de générer votre landing de SAAS IA.

Merci pour la lecture de cette édition,

Excellent mardi,

Jean-Baptiste.

Comment rendre un LLM déterministe ? (en gros, qu’il réponde toujours de la même manière)