- L'hebdo de MAIjin

- Posts

- Le guide avancé de prompt engineering chat gpt

Le guide avancé de prompt engineering chat gpt

Il est difficile de lire des informations fiables sur le prompt engineering.

Je vois deux extrêmes :

Les influenceurs affirmant que faire agir Chat GPT comme Elon Musk ou “écrivain célèbre” produit de meilleurs résultats.

Les développeurs qui proposent des prompts à rallonge faisant fuir les néophytes

Alors, quelle est la vérité ?

Il suffit de se tourner vers l’entreprise référence dans le domaine : Open AI.

Et justement…

Open AI vient de révéler les meilleures pratiques en prompt engineering.

J’ai parcouru ce document pour vous.

Et dans les minutes qui suivent, je vais vous partager les 20% d’informations qui produisent 80% des résultats.

Je vous partagerai des exemples concrets de mise en application de ces techniques dans GPT-4, avec les conversations en appui.

Je terminerai par vous proposer “l’anatomie du prompt parfait”, que vous pourrez utiliser à votre guise pour améliorer vos réponses avec Chat GPT.

Si vous avez 10 minutes, celles-ci seront bien investies dans la lecture de cet article.

On y va !

En résumé : les 6 stratégies de prompt engineering pour obtenir de meilleurs résultats avec Chat GPT

Les 6 stratégies que Open AI révéle fonctionnent mieux avec GPT-4.

De plus, ces stratégies peuvent être utilisées de concert pour de meilleurs résultats.

En voici un résumé très bref avant de passer au concret :

Stratégie #1 de prompt engineering : Rédigez des instructions claires :

Les modèles GPT ne peuvent pas lire dans vos pensées. Il est donc important de donner des instructions précises et détaillées pour obtenir les résultats souhaités.

Stratégie #2 : Fournir un texte de référence :

Les modèles GPT peuvent parfois inventer des réponses, surtout lorsqu’ils sont interrogés sur des sujets complexes. Fournir un texte de référence peut aider à obtenir des réponses plus précises.

Stratégie #3 : Divisez les tâches complexes en sous-tâches plus simples (en mode “ingénieur allemand”)

Tout comme en ingénierie logicielle, il est utile de décomposer une tâche complexe en une série de sous-tâches plus simples. Les tâches complexes ont tendance à avoir des taux d’erreur plus élevés que les tâches simples.

Stratégie #4 de prompt engineering : Donnez du temps aux GPT pour “réfléchir”

Les modèles GPT font plus d’erreurs de raisonnement lorsqu’ils essaient de répondre immédiatement, plutôt que de prendre le temps de travailler sur une réponse.

Demander une chaîne de raisonnement avant une réponse peut aider les GPT à raisonner plus efficacement.

Stratégie #5 : Utilisez des outils externes :

Compensez les faiblesses des GPT en leur fournissant les résultats d’autres outils.

Par exemple, un système de récupération de texte peut informer les GPT sur les documents pertinents.

Stratégie #6 : Testez les modifications de manière systématique :

Il est plus facile d’améliorer les performances si vous pouvez les mesurer.

Il peut être nécessaire de définir une suite de tests complète pour s’assurer qu’une modification améliore réellement les performances.

Quelles sont les meilleures stratégies de prompt engineering ? + 15 exemples concrets

J’ai sélectionné pour vous les tactiques qui me semblaient le plus utiles au jour le jour.

Elles font partie de la stratégie 1 et 2 principalement.

C’est parti !

Stratégie #1 : Rédigez des instructions claires

Tactique A : Inclure des détails dans vos prompts pour obtenir des réponses plus pertinentes

Tactique 2 : Attribuer un rôle à l’intelligence artificielle

Vous pouvez définir un rôle précis à l’intelligence artificielle, en rapport avec la tâche que vous lui demandez de réaliser.

Exemple dans Chat GPT :

(Agis comme un rédacteur SEO spécialisée dans l’intelligence artificielle Et propose moi 5 mots clés pour ranker sur google sur la requête “prompt engineering”)

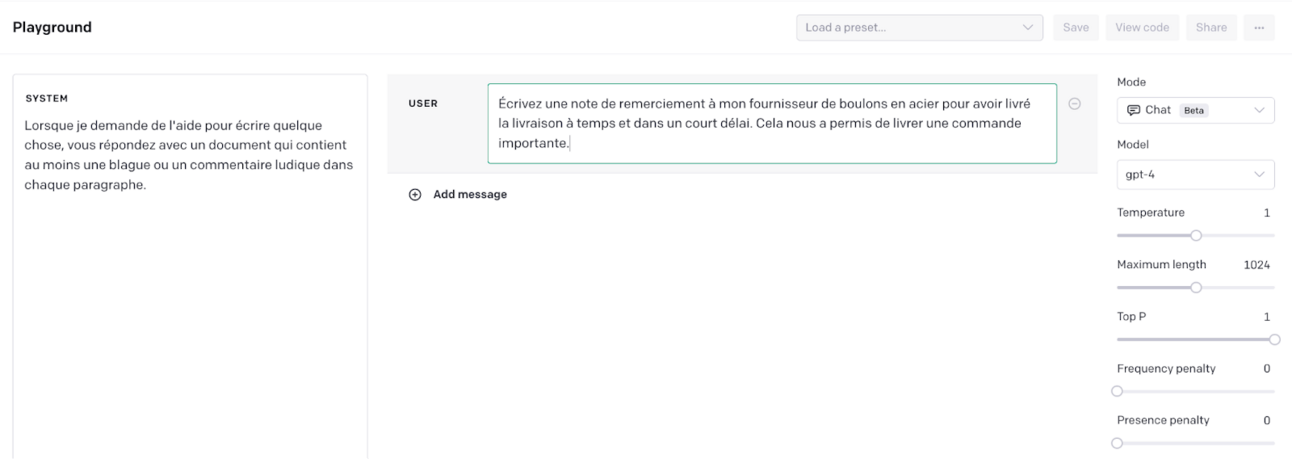

Exemple dans Playground d’Open AI :

Open AI montre plusieurs exemples dans Playground, une interface différente à Chat GPT.

Dans le playground, vous avez l’onglet “System” où vous pouvez définir le rôle de l’IA.

Et dans User, vous entrez votre demande.

Notez bien : le rôle que vous attribuez à la machine peut être davantage qu’un métier qu’il doit endosser.

Dans l’exemple de Playground, voici les instructions : “Lorsque je demande de l’aide pour écrire quelque chose, vous répondez avec un document qui contient au moins une blague ou un commentaire ludique dans chaque paragraphe.”

Dans Chat GPT, vous auriez pu dire :

Tactique C : Utilisez des délimiteurs pour indiquer clairement les parties distinctes de l’entrée

Open AI propose d’utiliser les guillemets triples ”””, les balises XML, les titres de section comme délimiteurs.

Rassurez-vous, je vais montrer des exemples :

Open AI souligne que les délimiteurs ne font pas de différence sur la qualité de la sortie pour les tâches simples. En revanche, cela fait la différence sur des tâches complexes.

De mon côté, je trouve que ça ajoute de la clarté au prompt, ce qui est bénéfique.

Tactique D : Spécifiez les étapes requises pour accomplir une tâche

Certaines tâches seront mieux effectuées par la machine en précisant les étapes.

Tactique E : Fournir des exemples (few shot prompting)

Il n’est pas toujours nécessaire d’utiliser ce type de prompt appelé “few shot prompting”

Dans le cas où vous souhaitez que le modèle copie un style particulier de réponse aux prompts des utilisateurs qui est difficile à décrire explicitement, alors c’est utile.

Si vous voulez développer un service client avec un style de réponse particulier par exemple… (de l’humour, des tournures de phrases particulières…)

Tactique F : Spécifiez la longueur souhaitée de la sortie

Vous pouvez demander à Chat GPT de produit des réponses d’une longueur donnée.

Vous pouvez la spécifier en termes de :

nombre de mots

nombre de paragraphes

nombre de bullets points

Notez bien que le nombre de mots ne fonctionne pas correctement.

Open AI suggère davantage de parler de nombre de paragraphe ou de bullets points.

Stratégie #2 : Fournir un texte de référence

Tactique A : Demander au modèle de répondre à l’aide d’un texte de référence

L’idée est de fournir des informations fiables et pertinentes en entrée et de donner des réponses à partir du texte de référence.

Comme GPT-4 a une mémoire de seulement 25 000 mots, vous pouvez utiliser des intégrations (comme les plugins chat gpt) pour mieux rechercher les réponses à une question poser.

Je vais vous donner un exemple sans plugin et avec plugin :

Avec plugin Link Reader :

Tactique B : demander au modèle de répondre avec des citations d’un texte de référence

Si l’entrée a été complétée par des connaissances pertinentes, il est simple de demander au modèle d’ajouter des citations à ses réponses en référençant des passages des documents fournis.

Avec le plugin Chat GPT Link Reader :

Comment rédiger un prompt parfait ?

Pour un prompt parfait, voici ce que vous devez respecter :

Inclure des détails dans vos requêtes pour obtenir des réponses plus pertinentes

Attribuer un rôle à l’intelligence artificielle

Utilisez des délimiteurs pour indiquer clairement les parties distinctes de l’entrée

Spécifiez les étapes requises pour accomplir une tâche

Fournir des exemples (few shot prompting)

Spécifiez la longueur souhaitée de la sortie

Demander au modèle de répondre à l’aide d’un texte de référence

Demander au modèle de répondre avec des citations d’un texte de référence

Voici un exemple de prompt à utiliser avec le plugin WebPilot de GPT-4 :

Alternative avec Link Reader + Zapier

J’aurais pu rajouter des exemples de mes meilleurs posts Linkedin aussi lors de l’étape 4.

En étape 5 : j’aurais pu demander de m’automatiser ce post avec zapier pour Linkedin.

On essaye ?

Ça marche et c’est qualitatif !

Regardez :

Besoin d’aide pour rédiger vos prompts ? Contactez moi sur Linkedin.

Vous n’avez ni le temps ni l’envie de rédiger un prompt avancé ?

Pourtant, vous voyez la valeur ajoutée que ça pourrait avoir dans votre activité ?

Merci de m’avoir lu jusqu’au bout,

Belle journée,

Jean-Baptiste.

Foire aux questions sur le prompt engineering

Qu’est-ce que le “prompt engineering” et pourquoi est-ce crucial pour l’utilisation efficace des modèles GPT ?

Le “prompt engineering” est une spécialité qui se concentre sur la création et l’amélioration des instructions pour les systèmes d’IA qui reposent sur le traitement du langage naturel.

Un “prompt engineer” est un spécialiste qui veille à ce qu’une IA produise des résultats précis, pertinents et utiles en optimisant l’entrée (invite) fournie au système. Sa connaissance des nuances des systèmes d’IA et du langage humain lui permet de combler efficacement le fossé entre les humains et les machines.

Le “prompt engineering” est crucial pour l’utilisation efficace des modèles GPT car sans instructions claires et précises, les réponses des IA génératives peuvent s’avérer décevantes. Le “prompt engineer” exprime avec clarté et précision ses objectifs de façon à ce que l’IA puisse comprendre et interpréter correctement les informations fournies. Dans une logique d’amélioration continue, le “prompt engineer” évalue régulièrement les performances des IA génératives pour entreprendre les ajustements nécessaires.

Comment le “prompt engineering” peut-il améliorer la qualité des résultats obtenus avec GPT-4 ?

Le “prompt engineering” peut améliorer la qualité des résultats obtenus avec GPT-4 en optimisant la formulation des prompts.

Les “prompt engineers” expérimentent différentes structures de prompts pour améliorer les performances des modèles. Ils testent les performances du modèle d’IA en évaluant les réponses à diverses prompts afin d’évaluer la précision, la pertinence et la sécurité. Ils identifient également les biais dans les résultats du modèle afin de les atténuer.

En outre, les “prompt engineers” collaborent étroitement avec les chercheurs en intelligence artificielle pour affiner la formation des modèles et améliorer les performances. Ils documentent les meilleures pratiques et partagent leurs stratégies de conception d’invites efficaces avec les équipes.

En fin de compte, le travail des “prompt engineers” contribue à créer des produits pilotés par l’IA plus efficaces, plus conviviaux et plus fiables.

L’article Le guide avancé de prompt engineering chat gpt est apparu en premier sur Académie du Web 3.0.

Reply